Порнография, пропаганда, пранки — все это активно создается с помощью нейросетей. Как распознать фейки , созданные AI

Kак распознать фейки AI

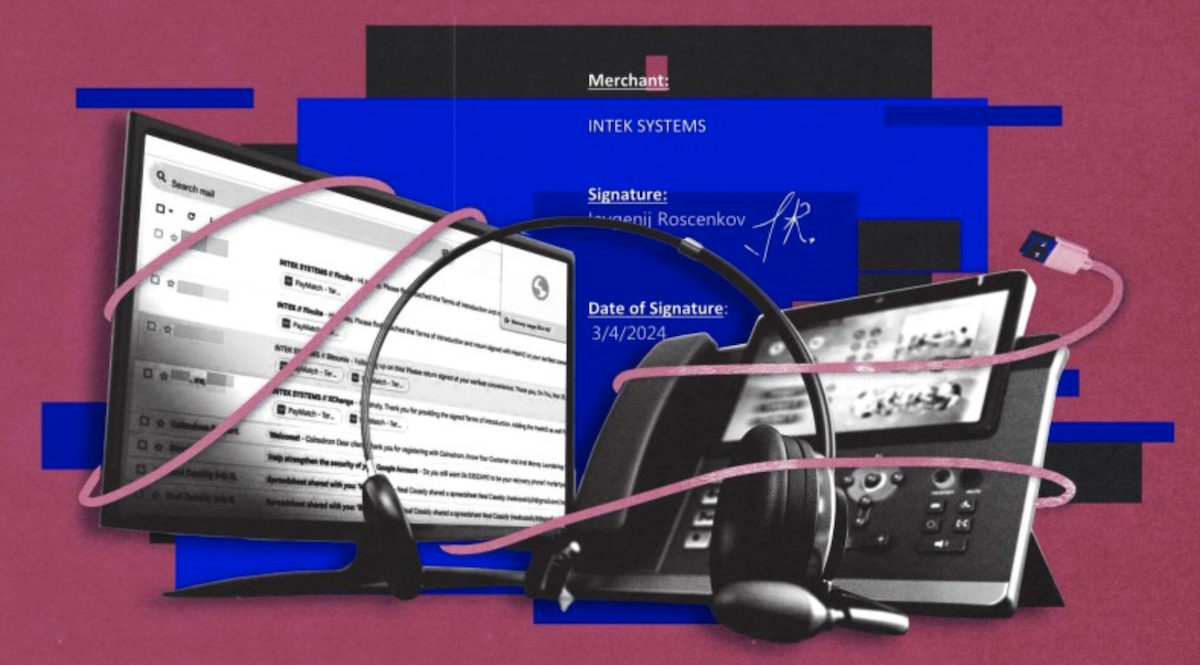

30 мая 2024 года OpenAI выпустила первый в своем роде отчет, согласно которому за последние три месяца компания обнаружила и заблокировала пять скрытых кампаний по влиянию. Операции проводились государственными и частными акторами из Китая, Израиля, России и Ирана. Злоумышленники использовали генеративный ИИ OpenAI для создания и распространения пропаганды в социальных сетях.

Так, российские кампании критиковали США, Украину и страны Балтии, в частности, используя ChatGPT для создания бота для Telegram. Акторы из Китая производили контент на различных языках для Х и Medium. Иранские акторы генерировали целые статьи против США и Израиля, переводя их на английский и французский. Израильская фирма Stoic создавала фейковые аккаунты и различный контент, обвиняющий в антисемитизме американских студентов, протестующих в защиту Палестины.

Порнография, пропаганда, пранки, мошенничество и фейки — все это сейчас активно создается с помощью нейросетей или так называемого генеративного искусственного интеллекта. Дезинформация, сгенерированная ИИ, представлена во всех возможных форматах: видео, изображения, аудио и текст. Никогда еще обман не был таким убедительным и таким простым в создании.

Наши партнеры из Factcheck.kz рассказывают, как бороться с дезинформацией, созданной с помощью ИИ, какие наиболее актуальные сервисы, помогающие распознавать дезинформацию, почему сегодня как никогда важно критическое мышление и каков накопленный мировой опыт в сфере законодательства, регулирующего нейросети и создаваемый ими контент. JAMnews публикует адаптированную версию материала.

Ожидания и реальность

Любую перспективную технологию человечество виртуозно умеет превращать в оружие. Нейросети не стали исключением. Как известно, ИИ демонизировался издавна, и в фантастических сюжетах, выходя из-под контроля, становился в ряд главных антагонистов цивилизации.

Это не мешало IT-гигантам активно инвестировать в ИИ, а ученым — развивать эту сферу. Уже сейчас видно, что генеративный ИИ стал революцией и изменит целые отрасли.

Задолго до появления Midjourney, ChatGPT и других систем на основе генеративного искусственного интеллекта, специалисты предрекали, что вместе с развитием ИИ, будет расти и угроза, которую он представляет для человечества. Но в то время для многих эти предупреждения звучали как обещания скорого Восстания машин в стиле “Терминатора”.

Однако сейчас можно констатировать, что использование генеративных моделей как минимум для создания дезинформации — вполне реальная угроза.

Аналитики Всемирного Экономического Форума в 2024 году назвали дезинформацию, созданную при помощи ИИ, самой серьезной угрозой мировому сообществу в краткосрочной перспективе. По мнению специалистов, передовые программы на основе искусственного интеллекта усиливают распространение ложной информации, которая угрожает подорвать демократию и поляризовать общество и является главным непосредственным риском для мировой экономики.

Инфографика из доклада ВЭФ. Эксперты назвали мисинформацию и дезинформацию самой большой угрозой в ближайшие два года.

В начале 2023 года специалисты из OpenAI совместно со Стэндфордской интернет-обсерваторией и Центром безопасности и новых технологий при Университете Джорджтауна выпустили доклад о потенциальных рисках использования больших языковых моделей — таких как Gemini или Chat-GPT — в целях дезинформации. Аналитики компании признали: «Из-за того, что большие языковые модели всё больше распространяются […] в настоящее время практически невозможно гарантировать, что БЯМ никогда не будут использоваться для создания дезинформации».

При этом авторы доклада видят возможное решение проблемы распространения дезинформации в совместных усилиях социальных сетей, разработчиков ИИ программ и правительств. Однако специалисты предупреждают, что даже эти усилия по контролю за контентом могут оказаться недостаточными, чтобы справиться с лавинообразным развитием технологий.

Ему не нужны твои одежда и мотоцикл

Говоря об информационных рисках, которые представляет генеративный ИИ, мы, конечно, имеем в виду не сами программы, а их пользователей. Достаточно быстро мошенники, пранкеры и пропагандисты поняли, что с помощью нейросетей можно добиваться своих целей быстрее и эффективнее.

В результате вместо долгого и кропотливого монтажа теперь можно легко создавать видео- и аудиодипфейки со знаменитостями и политиками. Мошенники уже используют сгенерированные видео для рекламы своих схем (1, 2, 3) и даже выманивают крупные суммы у людей в реальном времени с помощью видеозвонков.

Уже много десятилетий мы боимся, что однажды суперкомпьютеры выйдут из-под контроля и начнут вредить человечеству. Но пока что мы сами успешно справляемся с этой задачей. Изображение сгенерировано нейросетью.

Но еще опаснее дипфейки, которые используются для политической манипуляции. С помощью дипфейков можно дискредитировать любого оппонента.

Так было с пранком антивоенных российских активистов, с дипфейк-видео с президентом Молдовы Майей Санду о грядущей мобилизации в стране. Или с аудиодипфейком с голосом мэра Лондона, в котором тот призывает отложить мероприятие в память о жертвах Второй мировой войны в пользу пропалестинского марша. Распространение последнего фейка чуть не привело к массовым беспорядкам.

Пропагандисты также взяли на вооружение генеративные нейросети. Например, некий новостной сайт, аффилированный с правительством Китая, с помощью ИИ распространял в казахстанском сегменте сети фейки об «американских биолабораториях в республике».

Российские пропагандисты с самого начала полномасштабного вторжения в Украину использовали дипфейки с высокопоставленными украинскими государственными деятелями. Чаще других, пожалуй, в таких “видео” используют образ Владимира Зеленского. Например, фейк о капитуляции Украины или с призывом сдать Авдеевку.

Мировое сообщество обеспокоено тем, как сгенерированные фейки могут повлиять на демократию. Изображение сгенерировано нейросетью.

Серьезные опасения вызывает влияние сгенерированной дезинформации на электоральный процесс. В 2024 пройдут выборы в 50 странах по всему миру, включая многие европейские страны и США. Мы уже наблюдали, как нейросети использовались на выборах в Пакистане, Индонезии, Индии и Словакии.

На этот момент сгенерированная дезинформация не нанесла серьезного ущерба глобальному избирательному процессу. Однако до конца года еще далеко, и неизвестно, как дипфейк-кампании повлияют на грядущие выборы.

Видеть — значит, верить

Проблема распространения ИИ-дезинформации заключается даже не в количестве сгенерированных фейков, хотя их число значительно возросло за последние пару лет, а в том, что технологии создания подделок стали доступны любому, у кого есть доступ в интернет. При этом сами подделки настолько реалистичны, что определить их искусственную природу бывает очень трудно без специальных навыков и инструментов.

Одновременно с этим виральность ИИ-фейков так велика, что даже при оперативной работе фактчекеров распространение дезинформации невозможно остановить. Более того, дезинформация влияет на мировоззрение и уровень доверия к медиа даже в тех случаях, когда поддельная природа сообщения становится известна, и создатели фейков, вероятно, об этом прекрасно знают.

К сожалению, когнитивные искажения, из-за которых люди «держатся» за ложную информацию даже после опровержения, не единственная особенность нашей психики, которая играет на руку распространителям ИИ-дезинформации.

Дезинформация влияет на человека даже после того,

как он сталкивается с её опровержением (Иллюстрация: Midjourney)

Ученые из Цюрихского университета выяснили в ходе эксперимента, что люди более склонны верить фейковым сообщения, которые созданы ИИ, чем тем, что написаны людьми. Вероятно, сгенерированные тексты кажутся более правдоподобными из-за более четкой структуры и краткости изложения. Отметим, что разница в пользу ИИ составила всего три процента, но исследователи, использовавшие в эксперименте ChatGPT-3, предполагают, что процент будет увеличиваться, если задействовать более продвинутые версии больших языковых моделей.

Еще одну особенность восприятия дипфейков — сродни эффекту Данинга-Крюгера — обнаружили ученые из Института Макса Планка и Амстердамского университета. В результате экспериментов выяснилось, что неподготовленные зрители не отличают реальные видео от дипфейков, но при этом оценивают свои способности в распознавании подделок как достаточно высокие. Отягчающим фактором можно считать то, что в большинстве случаев испытуемые принимали фейковые видео за реальные, а не наоборот.

Эффективными средствами для нейтрализации когнитивных искажений и противостояния дезинформации считаются информационная грамотность и пребанкинг. «Кампании по повышению медиаграмотности крайне важны, если мы хотим минимизировать ущерб, причиняемый дипфейками. Если научить аудиторию мыслить как фактчекеры, можно значительно снизить скорость, с которой широкая публика распространяет дезинформацию, и ослабить стимул для тех, кто стоит за ее созданием», — считает Инок Нярики, менеджер по работе с сообществом в Международной сети по проверке фактов IFCN.

А как же инструменты по обнаружению следов искусственного интеллекта?

Программы по обнаружению следов ИИ в видео, изображениях или текстах — важный инструмент, но для рядового пользователя они не так полезны и эффективны, как критическое мышление и внимательность.

На сегодняшний день идентификаторы ИИ остаются по большей части профессиональным инструментом для бизнеса, журналистов и фактчекеров. Многие программы либо целиком, либо в расширенном функционале доступны только по корпоративной подписке или за плату. Для такого положения вещей есть несколько причин.

Разработка качественных многофункциональных инструментов для идентификации сгенерированного контента требует ресурсов, поэтому закономерно, что компании, разрабатывающие идентификаторы ИИ заинтересованы в монетизации своего продукта. Особенно учитывая, что инвесторы, судя по всему (1, 2), уделяют технологиям по определению следов ИИ меньше внимания, чем разработкам самого генеративного ИИ.

Следующая вероятная причина небольшого количества общедоступных инструментов по определению ИИ заключается в том, что, получив доступ к открытому инструменту, можно очень быстро создать программу, которая будет уметь этот инструмент «обманывать». Поэтому разработчики вынуждены искать компромисс между доступностью и эффективностью своего продукта.

Еще один важный фактор, ограничивающий доступ к специальным программам для широкой публики, заключается в том, что для правильного использования программой и интерпретации результатов необходимы определенные навыки и знания. Тщательная верификация информации требует внимания, которого часто не хватает широкой публике, говорит Энджи Холан, директор IFCN и бывшая редактор портала PolitiFact. В некоторых случаях проверка дезинформации требует специальных навыков по поиску информации, которых также нет у неспециалистов. Кроме того, рядовой потребитель новостей должен обладать достаточно высокой мотивацией, чтобы иметь стимул воспользоваться платной программой для определения следов ИИ.

Любой желающий может воспользоваться такими программами, как Deepware или AI or Not, но понять, что означают полученные результаты — особенно, если они разнятся в разных программах — задача со звездочкой. У некоторых инструментов по обнаружению следов ИИ вердикт обозначается в процентах вероятности, у других результат выводится в одной из нескольких категорий, например «скорее всего создано ИИ» или «скорее всего создано человеком». Некоторые программы используют также более продвинутые средства визуализации, например, графики и «тепловые карты», которые может быть сложно правильно интерпретировать без дополнительной подготовки.

Источник: AI or Not

Что касается эффективности инструментов, часто она все еще оставляет желать лучшего. Особенно сложно техническим инструментам правильно идентифицировать сгенерированные текст и аудио. В частности, детекторы ИИ показывают совершенно разные результаты, если поменять местами абзацы в тексте или отправить на проверку аудиофайл, который множество раз скачивали и снова заливали в сеть. Поэтому для надежного определения дипфейка стоит полагаться не только на специальные программы по идентификации ИИ, но и на другие инструменты, а также на внимательность, критическое мышление и знание маркеров ИИ в различных модальностях.

Если вам все же необходимо прибегнуть к помощи технических анализаторов, можем посоветовать следующие детекторы, которые использовали в своей практике.

Мы выбрали именно эти программы из-за их доступности, удобства использования и относительной эффективности. Но, к сожалению, ни один из этих анализаторов не безупречен, и лучше не полагаться только на их вердикты, но также анализировать изображения, аудио или видео с помощью других средств и методов.

- AI or Not — анализирует изображения и аудио. С первым — по нашему опыту — справляется вполне достойно, но с аудиодипфейками работает уже не так уверенно. Бесплатная базовая проверка 10 изображений и аудио доступна после регистрации, далее тарифы начинаются от 5 долларов в месяц.

- Undetectable AI — проверяет текст на следы ИИ. Показывает программы с помощью которых, вероятно, был сгенерирован текст. Доступен без регистрации. К сожалению, склонен давать ложноположительные результаты.

- DeepFake-o-Meter — анализирует изображения, аудио и видео. Позволяет выбрать детектор из списка доступных вариантов от различных разработчиков. Есть опция не сохранять проверяемые файлы на сервере, что может быть актуально, если вы работаете с чувствительной информацией. Инструмент бесплатный, доступен после простой регистрации. Увы, не все детекторы успешно определяют сгенерированный контент, хотя в отдельных случаях программа показала себя лучше конкурентов.

- Deepware — определяет дипфейк в видео. Можно загружать свои файлы, а можно по ссылке из YouTube, Facebook или X. Работает как агрегатор — показывает результат различных детектеров в процентах вероятности следов ИИ. Не всегда выдает достоверный средний результат, но неплохо справляется с виральными фейками.

- AI Speech Classifier от ElevenLabs — распознает сгенерированное аудио, созданное с помощью нейросети ElevenLabs. Доступен без регистрации и ограничений на количество проверок. По нашему опыту анализатор справляется неплохо, но, судя по тому, что программа не распознала следы ИИ в фейковой записи голоса президента США, эффективность детектора может быть не такой постоянной.

Глаз — алмаз

Хотя технологическое совершенствование генеративного ИИ грозит тем, что однажды сгенерированный контент станет невозможно отличить от настоящего, на сегодняшний день распространители фейков не особо утруждают себя составлением качественных подделок.

Во многих виральных видеодипфейках и сгенерированных изображениях подделку можно было определить невооруженным глазом. В числе таких фейков «фотографии» президента Франции Эмануэля Макрона — якобы во время беспорядков в Париже, недавний фейк с Дональдом Трампом якобы в окружении его темнокожих сторонников и видеофейк «интервью» секретаря СНБО Украины Алексея Данилова, где тот якобы подтверждает причастность Украины к теракту в московском «Крокус Сити Холле».

Причина, по которой эти сообщения распространились, заключается не в высоком качестве фейка, а в невнимательности зрителей, склонности искать подтверждение своей точки зрения и делиться сенсационными новостями, не проверяя их правдивость. Создатели фейков знают об этих слабостях нашего восприятия и рассчитывают на быстрое распространение фейков, а посредственное качество подделок этому не препятствует.

И здесь снова поможет информационная грамотность. В этой статье мы не будем подробно рассказывать о методах обнаружения ИИ-фейков, об этом уже создано немало достойных материалов: как распознать сгенерированное аудио, изображение или видеодипфейк. Однако отметим, что для борьбы с дезинформацией, созданной ИИ, достаточно соблюдать пару простых правил:

- Внимательно изучать материал, которым вы собираетесь поделиться, обращая внимание на детали изображения. Такие явные маркеры ИИ, как лишняя рука на изображении или неестественная мимика человека на видео, можно упустить, если просматривать новость поверхностно.

При беглом просмотре можно не заметить, что у мужчины справа три руки. Источник: X - Убедитесь, что источники сообщения заслуживают доверия.

- Не ленитесь и пользуйтесь методом латерального чтения, чтобы перепроверить информацию — возможно, фактчекеры уже опровергли ее.

Меры по контролю искусственного интеллекта

Дезинформация, созданная с помощью нейросетей — достаточно новый вызов для мирового сообщества. Поэтому правовые рамки использования генеративного ИИ как внутри стран, так и на международном уровне еще только устанавливаются, а их эффективность будет видна только по прошествии времени.

В исторической перспективе генеративный ИИ появился совсем недавно, поэтому, насколько эффективными окажутся законодательные меры по контролю за использованием нейросетей — покажет время. Изображение сгенерировано нейросетью.

К сожалению, существующее законодательство на этот момент не препятствует распространению фейков, а скорее действует реактивно. При этом аналитики из сфер экономики и IT предполагают (1, 2), что эффективность любых мер по контролю ИИ всегда будет отставать от развития технологий.

Это не значит, однако, что ИИ не следует регулировать. По словам экспертов из Google, «ИИ слишком важная [технология], чтобы ее не регулировать, и слишком важная, чтобы не регулировать хорошо».

Михаил Климарёв, IT-специалист и директор организации «Общества защиты интернета» считает, что технически ограничить распространение сгенерированной нейросетями дезинформации невозможно, как и привлечь к ответственности создателей фейков — ведь часто они находятся за пределами тех стран, в которых распространяют дезинформацию. Однако можно законодательно обязать компании следить за качеством сведений, которые распространяются на их платформах или с помощью подконтрольных им технологий.

Основные игроки на рынке соцсетей — например X, YouTube, Facebook и TikTok — уже сформировали ряд мер, по контролю над сгенерированным или измененным контентом. В феврале Google, OpenAI, TikTok, Meta, Microsoft представили черновую версию соглашения по совместной разработке мер противодействия «предвыборной дезинформации, созданной искусственным интеллектом». В начале весны Meta и YouTube уже объявили о расширении правил маркировки сгенерированного контента, а Google заблокировал пользователям возможность задавать вопросы на тему выборов в своем чате Gemini.

Национальные законы и стратегии

Один из первых законодательных актов, косвенно связанных с работой искусственного интеллекта, появился в Южной Корее в 2008 году задолго до громкого появления генеративных моделей. Документ был направлен на регулирование развития и распространения «умных роботов». Руководства и правила для контроля технологий ИИ, применяющихся в разных сферах, постепенно появлялись и в других странах (1, 2).

Первой страной, которая опубликовала Национальную стратегию развития искусственного интеллекта, стала Канада. В документе содержатся четыре цели для достижения и программы реализации. Из них следует, что главным приоритетом для канадцев является поддержка исследований и талантов.

Почти одновременно с Канадой принял свой «План развития искусственного интеллекта нового поколения» Китай. Это наиболее обширный и всеобъемлющий проект по работе с ИИ.

При этом авторы китайского плана обращают внимание на то, что развитие искусственного интеллекта может таить в себе угрозу для безопасности, и это необходимо учитывать. В 2018 году в Китае появилась «Белая книга по стандартизации ИИ» (полный текст книги в редакции 2021 года здесь). Помимо инициатив по внедрению и управлению документ также освещает вопросы надежности и безопасности. Таким образом в сфере ИИ, с одной стороны, реализовываются проекты по масштабированию и развитию, а, с другой, по оценке и регулированию.

В 2020 году международное агентство HolonIQ сообщило о 50 национальных стратегиях в области искусственного интеллекта. В том же году была официально запущена OECD AI Policy Observatory — Обсерватория Организации экономического сотрудничества и развития (ОЭСР) по политике в области искусственного интеллекта. На данный момент OECD AI предоставила данные о более чем 1000 политических инициатив об ИИ в 69 странах мира. 354 из них направлены на руководство и регулирование в области ИИ, однако важно отметить, что основная часть носит общей рекомендательный характер.

Евросоюз, AI act как модельный закон

Больше всех, судя по всему, в сфере правового урегулирования работы ИИ нерекомендательного типа добился Евросоюз.

В 2019 году Еврокомиссия опубликовала досье «Укрепление доверия к человекоориентированному искусственному интеллекту». В нем перечислены рекомендации по созданию ИИ, заслуживающему доверия. Ключевые требования, которым должны соответствовать приложения ИИ:

- человеческая активность и надзор;

- техническая надежность и безопасность;

- конфиденциальность и управление данными;

- прозрачность;

- разнообразие, недискриминация и справедливость;

- социальное и экологическое благополучие;

- подотчетность.

В декабре 2023 года страны ЕС и Европейский парламент достигли соглашения по закону об искусственном интеллекте. В марте 2024 года Закон, известный как AI act, был принят Европарламентом. Уже сейчас его называют знаковым и высказывают мнение о том, что именно он станет отправной точкой для новой модели управления, построенной на технологиях.

Проект направлен на классификацию и регулирование приложений, использующих ИИ, и разделяет их на четыре категории в зависимости от уровня риска, который они представляют. Согласно регламенту, некоторые системы будут полностью запрещены (к примеру, часть из тех, что следит за людьми в режиме реального времени). Другие подвергнутся серьезной оценке, третьи же не будут подлежать надзору.

Также в документе указано, что искусственные или обработанные изображения, аудио- или видеоконтент («дипфейки») должны быть четко обозначены как таковые.

США

Еще одним важным событием в правовом поле является Указ о разработке и использовании искусственного интеллекта, подписанный в 2023 году в США. На сайте Белого дома говорится, что проект «устанавливает новые стандарты безопасности и защиты ИИ, защищает конфиденциальность американцев, продвигает справедливость и гражданские права, защищает потребителей и работников, способствует инновациям и конкуренции, продвигает американское лидерство во всем мире и многое другое».

Так, согласно новым требованиям, разработчики систем ИИ, представляющих угрозу национальной безопасности США, экономике, здоровью населения или безопасности, должны предоставлять правительству результаты испытаний на безопасность. Министерству внутренней безопасности поручено создать совет по безопасности ИИ и вместе с министерством энергетики противостоять угрозам, связанным с искусственным интеллектом/кибербезопасностью, а также химическим биологическим, радиологическим, ядерным рискам. Для защиты американцев от мошенничества с использованием ИИ министерство торговли разработает руководство по аутентификации контента и нанесению водяных знаков для четкой маркировки контента, созданного искусственным интеллектом.

Кроме того, в начале февраля 2024 года правительство США ввело запрет на роботизированные звонки, которые используют голоса, сгенерированные ИИ. Ограничение было принято на фоне происшествия в штате Нью-Гемпшир, где местным жителям стали массово поступать звонки якобы от президента Джо Байдена. Сгенерированный голос президента призывал своих сторонников не голосовать на предварительных президентских выборах.

Заключение

Для борьбы с дезинформацией, созданной нейросетями, нет никакого универсального средства. Для эффективного противодействия необходимы совместные усилия социальных сетей, разработчиков ИИ, журналистов и правительств, а также повышение медиаграмотности среди широкой публики.

Последнее сродни иммунизации через вакцинацию и выработку коллективного иммунитета. Только через информирование и обучение критическому мышлению можно снизить распространение и воздействие ИИ-фейков, защищая таким образом информационное пространство и демократию.

При поддержке Медиасети

exchange